들어가며

일반적으로 네이버에서는 티스토리 블로그가 따로 검색이 안되는데, 이를 해결하기 위해 네이버 서치 어드바이저라는 곳에 등록을 해주어야 한다. 오늘은 이 과정을 포스팅 해보려한다.

네이버 서치 어드바이저에 등록

https://searchadvisor.naver.com/tools/sitecheck

네이버

네이버에 로그인 하고 나를 위한 다양한 서비스를 이용해 보세요

nid.naver.com

일단 위 링크를 타고 들어가서 내 블로그 링크를 입력해준다.

이렇게!

그러면 위와 같이, 어떤 것이 돼있고, 어떤 것이 안돼있는지 진단이 나온다.

나의 경우 robot.txt 가 존재하지 않으므로 이에 대한 설정이 필요하다.

네이버 로봇 차단 설정/변경

https://searchadvisor.naver.com/guide/seo-basic-robots

robots.txt 설정하기

robots.txt는 검색로봇에게 사이트 및 웹페이지를 수집할 수 있도록 허용하거나 제한하는 국제 권고안입니다. IETF에서 2022년 9월에 이에 대한 표준화 문서를 발행하였습니다. robots.txt 파일은 항상

searchadvisor.naver.com

연결된 링크를 들어가보면,

대표적인 규칙은 아래와 같으며 사이트의 콘텐츠 성격에 맞게 변경해주세요.

- 다른 검색엔진의 로봇에 대하여 수집을 허용하지 않고 네이버 검색 서비스용 검색로봇만 수집 허용으로 설정합니다.

User-agent: * Disallow: / User-agent: Yeti Allow: / - 모든 검색엔진의 로봇에 대하여 수집 허용으로 설정합니다.

User-agent: * Allow: / - 사이트의 루트 페이지만 수집 허용으로 설정합니다.

User-agent: * Disallow: / Allow: /$ - 관리자 페이지, 개인 정보 페이지와 같이 검색로봇 방문을 허용하면 안 되는 웹 페이지는 수집 비허용으로 설정해주세요. 아래 예제는 네이버 검색 서비스용 검색로봇에게 /private-image, /private-video 등은 수집하면 안 된다고 알려줍니다.

User-agent: Yeti Disallow: /private*/ - 모든 검색로봇에게 사이트의 모든 페이지에 대하여 수집을 허용하지 않는다고 알려줍니다. 이 예제는 사이트의 어떠한 페이지도 수집 대상에 포함되지 않으므로 권장하지 않습니다.

위와 같은 설명글이 나옴을 알 수있다.User-agent: * Disallow: /

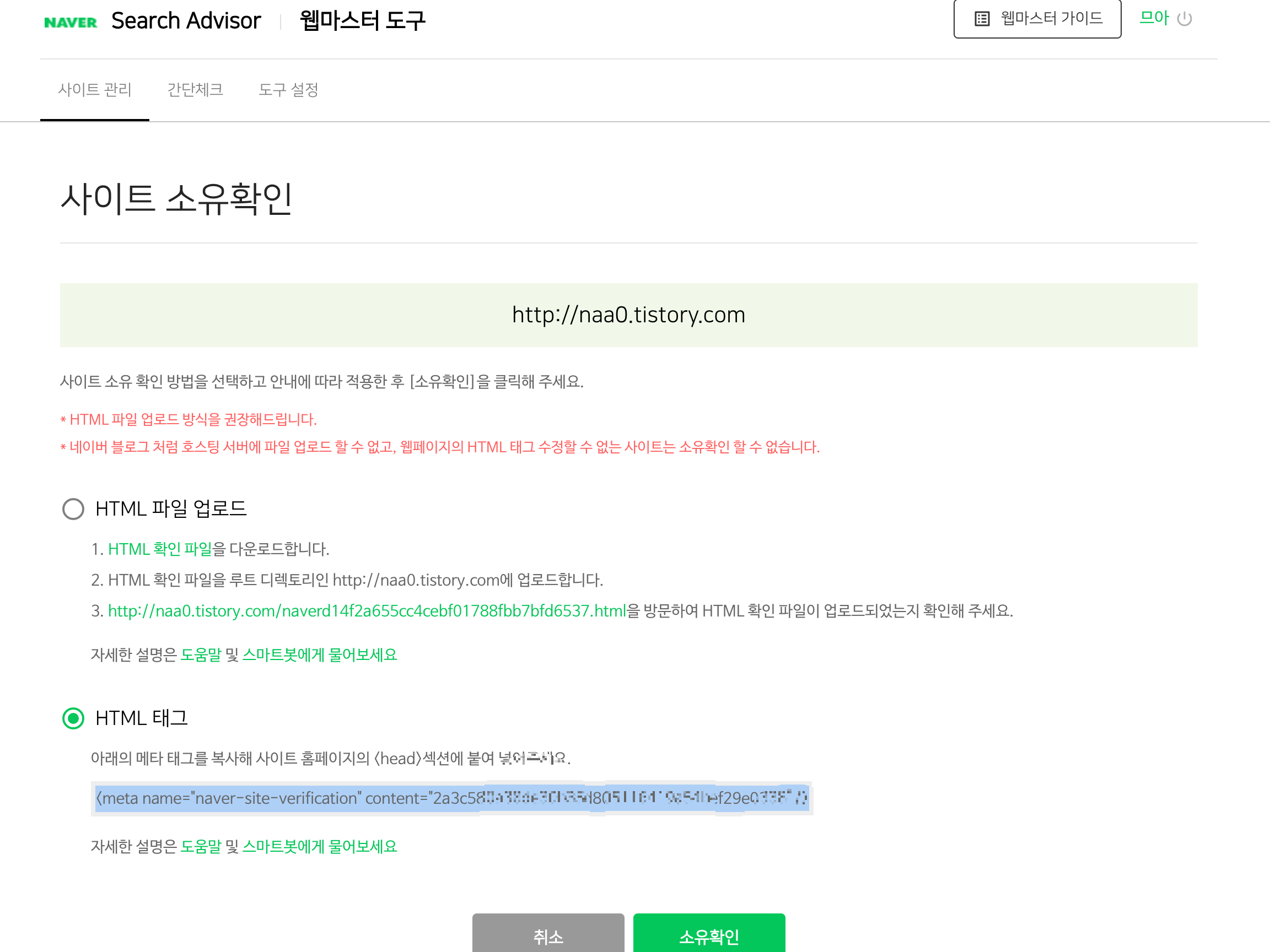

우선은 아래의 웹 마스터 도구를 들어간다.

https://searchadvisor.naver.com/console/board

그리고 티스토리 블로그에서 관리 > 스킨편집 > html 편집을 들어가서 적당히 head 태그 밑에 위에서 복사해둔 html 태그를 붙여넣어 준다.

그러면 우선 소유 인증은 완료된다.

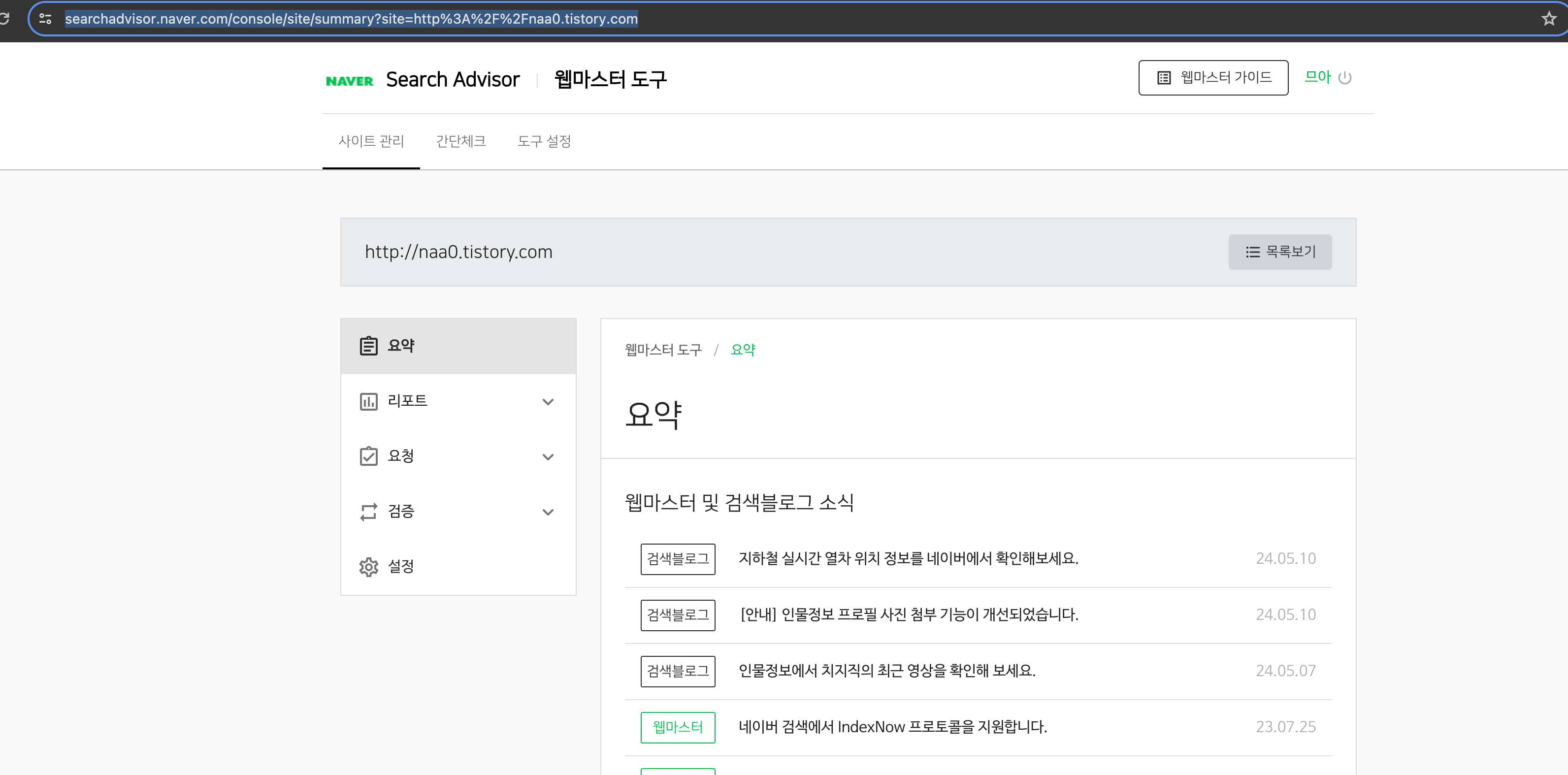

이후, 사이트 관리 콘솔창에서 블로그 주소를 클릭해본다.

그럼 대강 위와 같은 창으로 연결된다.

검증 탭에서 robots.txt 클릭 후 수집요청을 눌러준다.

생성된 robots.txt 파일을 다운받아준다.

해당 robots.txt 파일을 다시 티스토리 블로그 관리 > 스킨편집 > html 편집에서 이번에는 파일업로드 단에서 추가해준다.

잘 적용되었는 지 이제 콘솔창으로 돌아와 검증해본다.

이렇게 뜨면 완료이다.

다만, 등록 이후로 색인까지는 시간이 소요된다고 한다.

또한, 원하는 글이 있다면 수동 색인 가능하다고 하지만 그렇게까지는... 귀찮기 때문에 생략한다.

댓글